1. Elastic 머신 러닝 소개

Elastic Stack에 통합된 Elastic Machine Learning (ML) 기능은 대규모 데이터를 기반으로 자동화된 통찰력과 예측을 제공하는 강력한 도구입니다. 복잡한 기계 학습 알고리즘을 사용자가 쉽게 적용할 수 있도록 설계되어, 로그, 메트릭, 보안 이벤트 등 다양한 시계열 데이터에서 이상 징후(Anomaly)를 탐지하고 추세(Trend)를 예측하는 데 탁월한 성능을 발휘합니다.

Elastic ML은 크게 비지도 학습(Unsupervised Learning)과 지도 학습(Supervised Learning) 두 가지 유형의 분석을 지원합니다. 옵저버빌리티(observability)와 보안(security) 목적으로 사용되는 경우 비지도 학습을 통해 이상 행위를 분석 합니다. 비지도 학습은 Elastic ML의 핵심 기능으로, 레이블링된 훈련 데이터 없이 데이터 내의 정상적인 행동 패턴을 스스로 학습하여 비정상적인 이벤트를 식별합니다.

비지도 학습 기반의 탐지 방식은 다음과 같습니다.

시계열 기반 이상 징후 탐지 (Anomaly Detection)

- 시계열 기반 이상 징후 탐지 (Anomaly Detection) 방식: 로그, 메트릭 등 시간에 따라 변화하는 데이터에서 비정상적인 패턴을 실시간으로 식별합니다.

- Elasticsearch로 수집된 시계열 데이터에서 정상 상태의 통계적 모델을 자동 생성합니다.새로운 데이터 포인트가 모델에서 예측한 범위를 벗어날 경우, 이를 이상 징후로 플래그하고 **이상 징후 점수(Anomaly Score)**를 부여합니다.

- 이를 통해 시스템 성능 저하, 보안 위협, 애플리케이션 오류 등의 근본 원인을 신속하게 파악할 수 있습니다.

- 활용 사례: 서버의 CPU 사용률 급증, 웹 요청 응답 시간 지연, 네트워크 트래픽의 비정상적인 증가 등을 모니터링합니다.

예측 (Forecasting) 방식

- 예측 (Forecasting) 방식: 과거의 데이터 패턴을 기반으로 미래의 데이터 동작을 예측합니다.

- 활용 사례: 향후 리소스 요구 사항(예: 스토리지, 서버 부하)을 예측하여 용량 계획(Capacity Planning)에 활용하거나, 이상 징후가 발생하기 전에 선제적으로 대응합니다.

이상값 탐지 (Outlier Detection)

- 이상값 탐지 (Outlier Detection) 방식: 시계열 데이터가 아닌 정적인 데이터 세트에서 다른 데이터 포인트와 크게 동떨어진 개별 데이터 포인트를 식별합니다.

- 활용 사례: 사기 거래 탐지, 비정상적인 사용자 행동 분석 등에 사용됩니다.

지도 학습은 레이블링된 훈련 데이터 세트를 사용하여 모델을 구축하고, 이를 통해 새로운 데이터의 범주(분류)나 연속적인 값(회귀)을 예측합니다.

지도 학습 기반의 탐지 방식은 다음과 같습니다.

분류 (Classification)

- 분류 (Classification) 방식: 데이터 포인트를 이산적인 범주형 값으로 예측합니다 (예: 악성/정상, 스팸/비 스팸).

- 활용 사례: 보안 분야에서 잠재적인 악성 도메인 요청을 분류하거나, 사용자 피드백을 긍정/부정으로 분류합니다.

회귀 (Regression)

- 분류 (Classification) 방식: 데이터 포인트를 이산적인 범주형 값으로 예측합니다 (예: 악성/정상, 스팸/비 스팸).

- 활용 사례: 보안 분야에서 잠재적인 악성 도메인 요청을 분류하거나, 사용자 피드백을 긍정/부정으로 분류합니다.

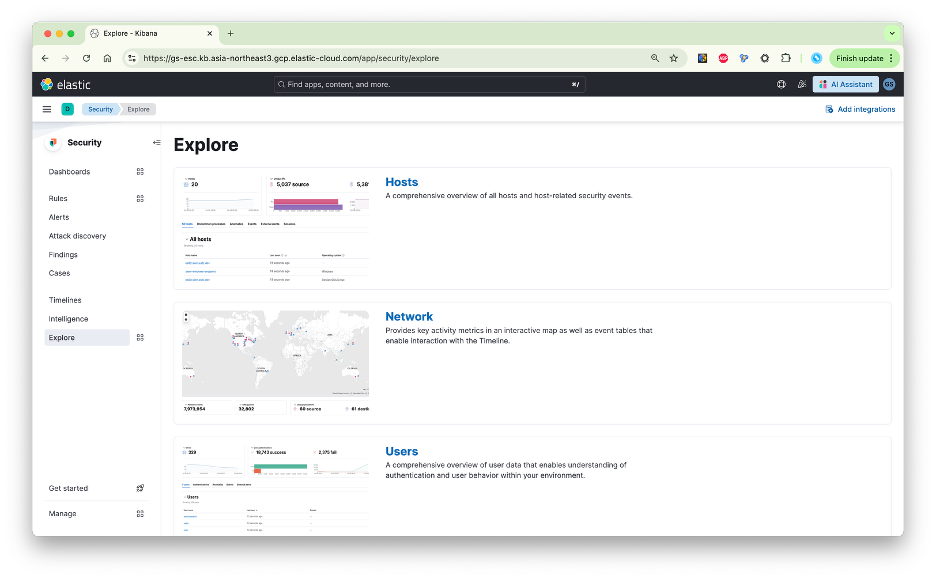

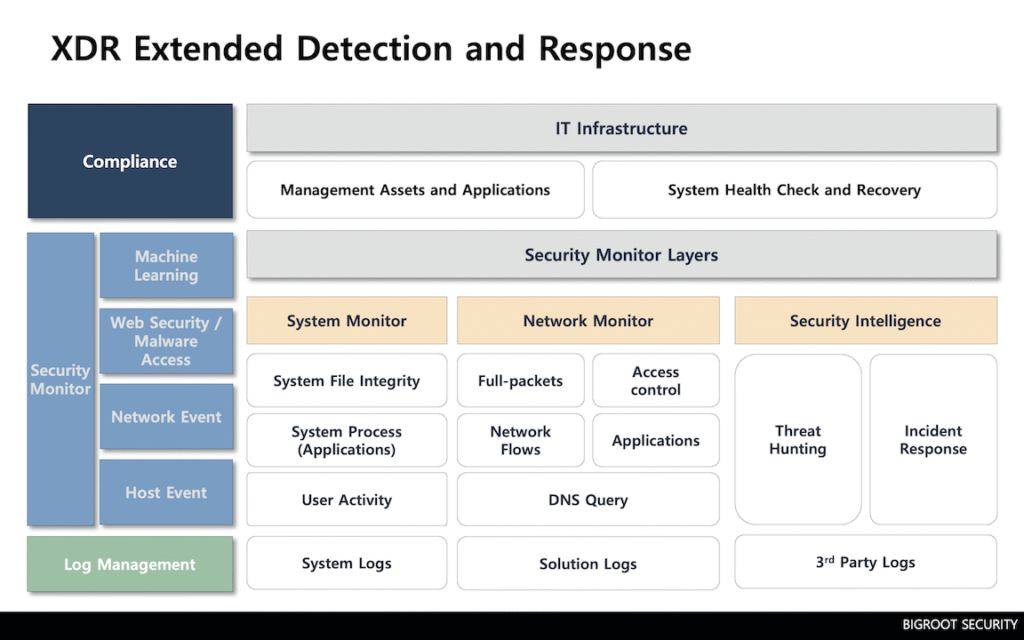

2. 머신 러닝 유즈케이스: 네트워크 이상 통신 분석

인프라팀과 보안팀에서는 네트워크 기반의 이상 행위 또는 이상 트래픽을 모니터하기 위해 다양한 장비의 로그를 수집해서 분석 합니다. 네트워크 기반의 로그의 경우 TCP/IP 기반의 네트워크 프로토콜 정보를 제공 합니다.

보안 위협을 식별하는 방법은 다양하며, 문자열로 된 공격 특징을 패턴으로 정의하여 공격을 식별하거나 특정 파일명 또는 IP 주소, 시스템 명령이 포함되지 않은 통신에서 관련 명령어 실행 여부 검색 등을 통해 보안 위협을 식별할 수 있습니다. 패턴 기반 식별 방법은 공격을 빠르게 구분하고 식별할 수 있어 가장 많이 사용되지만 공격과 관련된 패턴을 모르는 경우에는 탐지할 수 없거나 위협을 놓칠 수 있는 단점이 있습니다.

이러한 단점을 극복하고, 탐지 패턴을 알 수 없거나 제로데이 공격 위협을 식별하기 위해 이상 행위 분석(Anomaly Detection) 방법이 사용됩니다. 이상 행위 분석은 공격 특징을 가진 정형화된 공격이 아닌 비정형화된 공격을 탐지하기 위해 행위 분석을 통해 보안 위협을 식별하는 방식입니다.

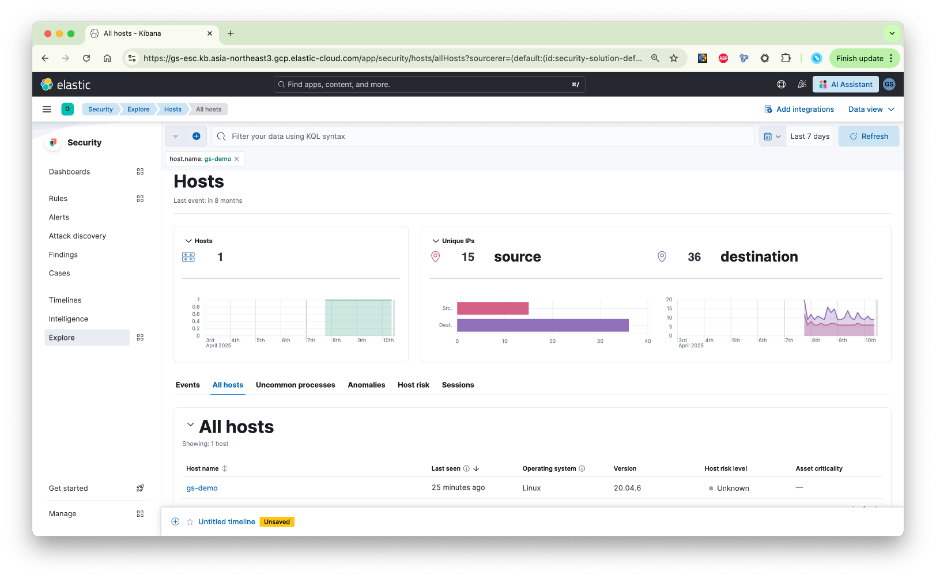

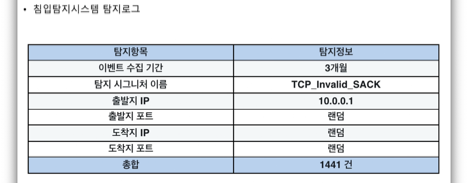

네트워크 TCP/IP 기반의 로그 정보를 이용해 보안 위협 관점에서 이상 행위 분석 과정을 상세히 살펴봅니다. 보안 솔루션의 탐지 로그(CSV 형식, 구분자 쉼표)를 사용하며, 총 8개의 컬럼(탐지 시간, 이벤트 탐지 카운트, 출발지 IP/PORT, 도착지 IP/포트, 오브젝트 타입, 프로토콜 유형)을 가진 로그입니다.

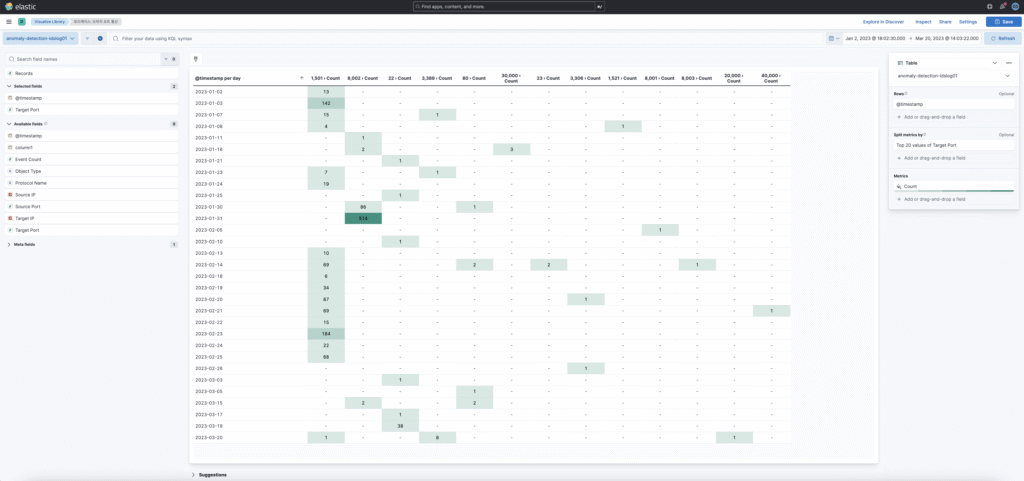

Kibana의 Visualize 기능을 사용하여 날짜별 통신 통계 정보를 표(Table)로 작성할 수 있습니다. 간단하게 통신 내역 통계를 확인할 수 있습니다.

하지만 실제 이상 행위에 대한 분석과 이상 행위에 대한 근거를 찾기는 어렵습니다. 수동 분석은 분석가의 역량에 따라 결과의 차이가 발생할 수 있기 때문에 분석 역량 편차를 극복하기 위해 머신러닝을 활용 할 수 있습니다. 앞서 표에 사용했던 포트 통신 정보를 머신 러닝 학습에 사용할 수 있습니다.

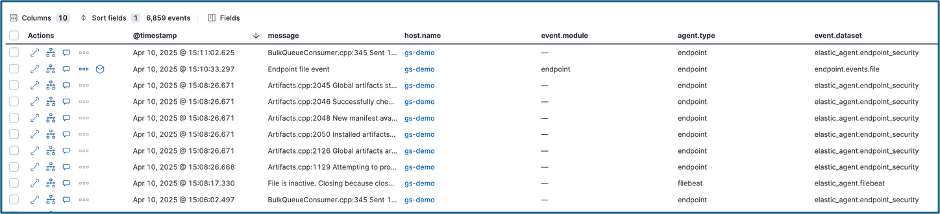

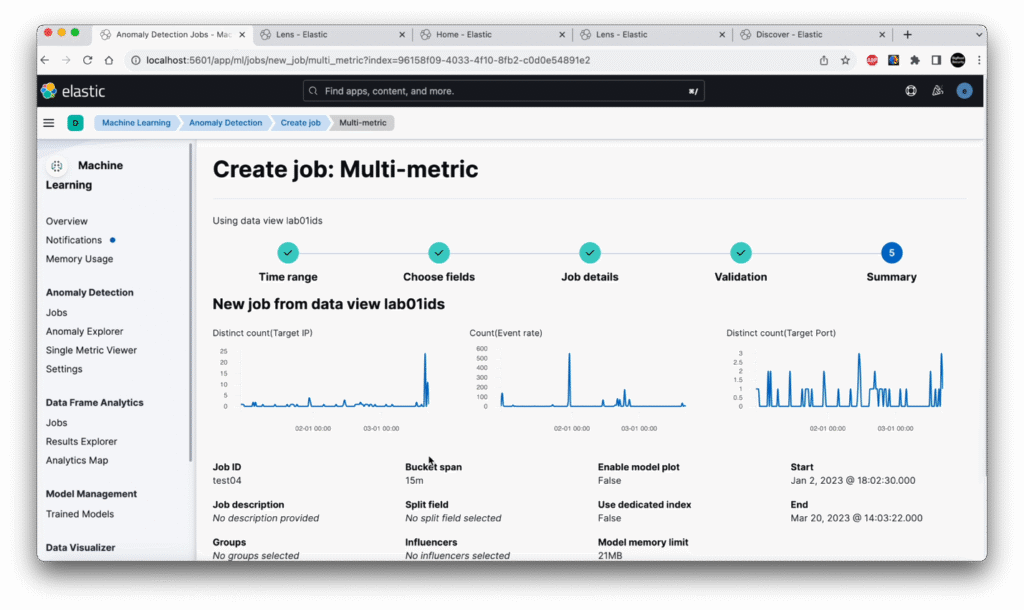

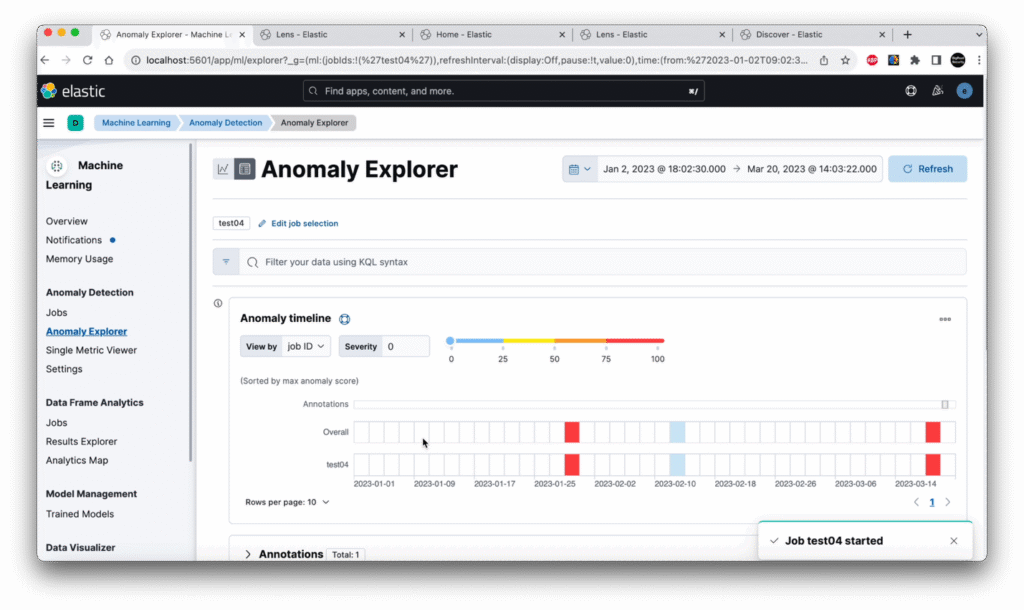

분석 과정은 다음과 같습니다. 통신 로그 분석을 통해 이상 행위에 대한 식별이 가능 합니다. 머신러닝을 이용한 이상 행위 분석은 Analytics 메뉴의 Anomaly Detection 기능을 사용하여 수행됩니다.

IDS 로그를 대상으로 도착지 IP, 도착지 포트, 이벤트 탐지 카운트를 선택하여 멀티 메트릭 분석을 진행 합니다.

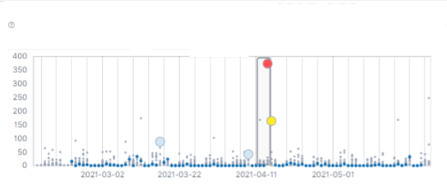

분석 완료 후 결과 보기를 통해 의심 행위를 확인할 수 있으며, 이상 행위가 식별된 타임라인은 빨간색으로 표기됩니다.

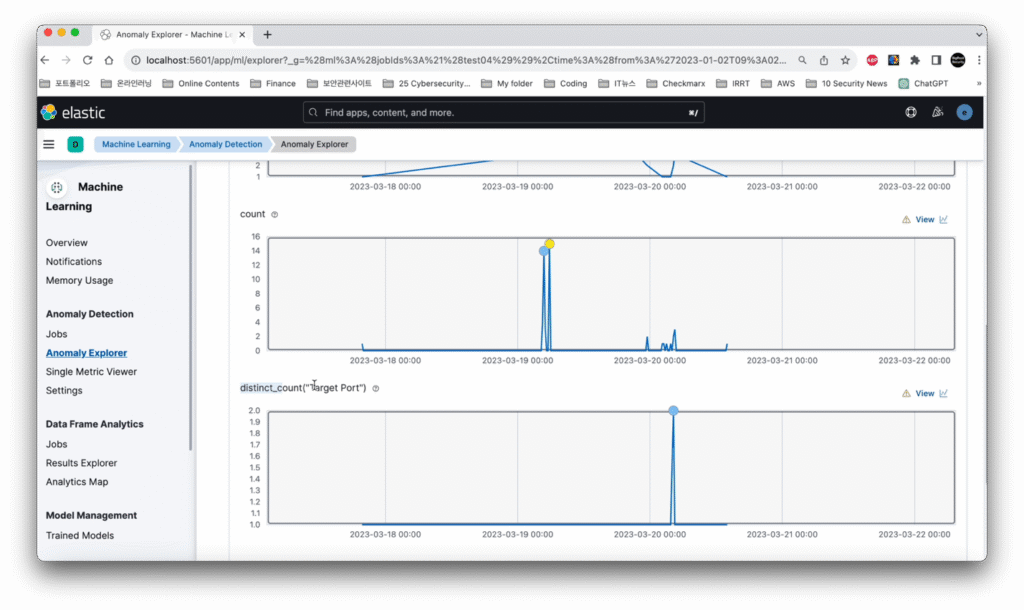

분석 그래프를 보면 3월 18일부터 그래프가 갑자기 증가된 것이 확인되며, 자세한 시간 정보에서는 이상 행위에 대한 스코어와 근거를 확인할 수 있습니다.

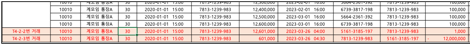

대상 IP 기준으로 분석된 내용을 보면 평소 1회 탐지되던 패턴이 11배로 증가하여 평소와 비정상적인 이상 현상이 발생했으며, 도착지 포트 탐지 횟수도 3월 19일 증가된 것을 확인했습니다. 통신 시간을 상세 분석한 결과, 새벽 05시에 통신이 집중되었으며, 몇 초 간격으로 서로 다른 도착지 IP로 통신이 이루어진 것을 확인했습니다. 이는 시스템 관리자가 SSH 통신을 하는 일반적인 간격(몇 분 이상)과 달리 아주 짧은 간격으로 발생했고3월 19일 하루만 갑자기 발생했다는 점에서 비정상적인 행위로 판단되었습니다.

결과적으로, 머신러닝을 통해 분석가의 편차와 상관없이22번 도착지 포트의 이상 행위와 대상 IP에 대한 이상 현상을 정확하게 식별할 수 있었습니다.

영상: https://youtu.be/EKV1gZjxPkU?si=iyigokW4TafX09ob

3. 머신 러닝 유즈케이스: 이상 ISP 식별

Elastic 머신 러닝 기능을 활용하여 네트워크 로그에서 잠재적인 보안 위협을 탐지하는 기술적 접근 방식은 조직의 보안 운영을 강화하는 핵심 유즈케이스 입니다.

특히 평소 네트워크 활동에서 관찰되지 않던 희귀한 ISP(Internet Service Provider) 정보나 새로운 ASN(Autonomous System Number)을 가진 대상과의 통신 패턴을 탐지하는 것은 무단 액세스나 데이터 유출 시도를 식별하는 매우 중요한 방법 중 하나입니다. 이러한 통신은 일반적인 비즈니스 트래픽이나 내부 사용자 활동에서는 전혀 예상되지 않는 주체와의 연결을 의미하며, 공격자가 숨겨진 인프라를 사용하고 있을 때 나타나는 의심스러운 징후가 됩니다.

이러한 유즈케이스를 탐지하기 위해 우리는 Elastic ML의 비지도 학습 기능(Unsupervised Learning)을 사용하여 네트워크 데이터의 정상적인 패턴을 학습하고 이 패턴에서 벗어나는 행위, 즉 희귀 이벤트(Rare Events)를 자동으로 찾아냅니다. 사용되는 ML Job은 RARE 디텍터를 이용합니다.

시간이 지남에 따라 각 대상의 ISP/ASN 정보별로 관찰되는 네트워크 활동의 정상 범위를 모델링하고 이 범위를 벗어나는 희귀한 활동을 이상 징후로 탐지합니다.

이 ML Job은 특정 대상의 ISP 또는 ASN 필드를 분석하고, 네트워크 트래픽 건수(count 함수)를 측정 지표로 사용합니다. 시간에 따른 각 대상 주체별 트래픽 패턴을 개별적으로 분석하여 평소 거의 혹은 전혀 트래픽이 발생하지 않던 ISP와 갑자기 통신이 증가하는 경우에 높은 이상 징후 점수(Anomaly Score)를 부여합니다.

- 한국 ISP 출발지

- 도착지 국가 정보가 한국

- 로그 필터 : source.geo.country_name: “South Korea” and network.transport: “TCP”

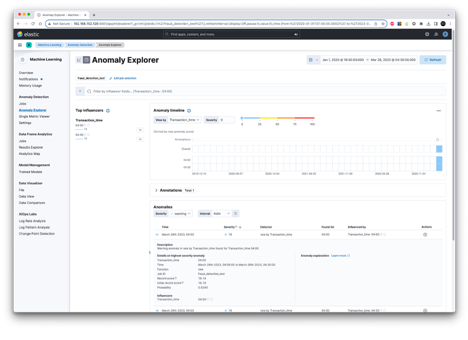

탐지된 이상 징후는 Kibana의 Anomaly Explorer에서 시각화되어 보안 담당자가 쉽게 확인하고 영향 요인(Influencers)을 분석할 수 있으며, 이때 대상 ISP 또는 ASN 필드와 트래픽 건수가 주요 영향 요인으로 표시되어 이상 활동의 근본 원인을 빠르게 파악할 수 있습니다.

특히 취약한 보안으로 해킹 중간 경유지로 사용되는 경우 대학/개인공유기/특정기관에서 사용하는 IP 정보와 연관되는 경우가 있습니다.

이를 통해 보안 팀은 공격자가 사용하는 희귀한 C2(Command and Control) 인프라와의 통신을 자동화된 방식으로 식별하고 신속하게 대응함으로써 조직의 민감한 정보를 보호할 수 있습니다.

4. 머신 러닝 유즈케이스: 알려지지 않은 신규 보안 위협 탐지

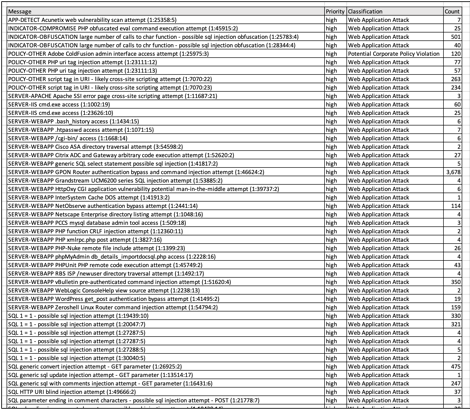

다수의 보안 장비에서 수집되는 공격 이벤트(알람)에는 고유의 이벤트(알람) 이름을 가지고 있습니다. 다음은 한달 동안 IPS에서 탐지된 이벤트 목록을 테이블로 정리한 예제 입니다.

탐지되는 공격 유형은 다양하고 하루에도 똑같은 이벤트가 수천 건 이상 탐지되고 이벤트를 발생 시킵니다. 반복적으로 발생되는 이벤트(알람)은 예외 처리를 통해 최적화 하고 이벤트 탐지 건수를 최적화해야 합니다. 이를 통해 공격과 연관된 이벤트에 집중할 수 있어야 합니다.

하지만 실제 운영 과정에서 모든 보안 이벤트를 최적화하는 작업은 쉽지 않습니다. 새로운 보안 위협을 식별하고 공격자에 의해 새롭게 발생하는 공격 탐지 이벤트(알람)를 식별하는 것은 기업 인프라를 보호하는 데 매우 중요한 유즈케이스 입니다.

머신 러닝을 통해 반복적으로 발생하는 이벤트를 제외하고 특정 기간 동안 탐지 되지 않은 보안 이벤트(알람)가 발생할 경우 보안팀에서 인지할 수 있다면 새로운 공격 위협이나 심각한 공격 행위를 구분하는데 매우 효율적으로 대응할 수 있습니다.

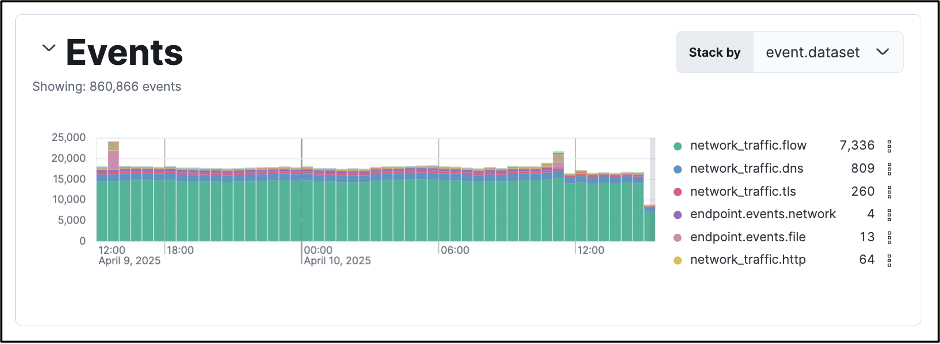

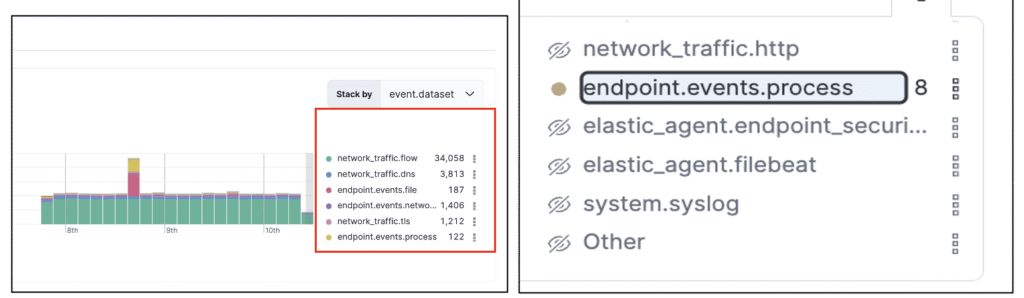

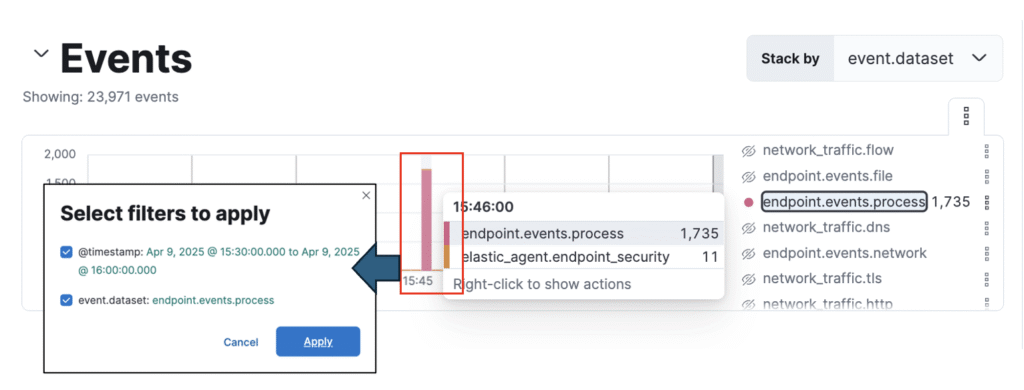

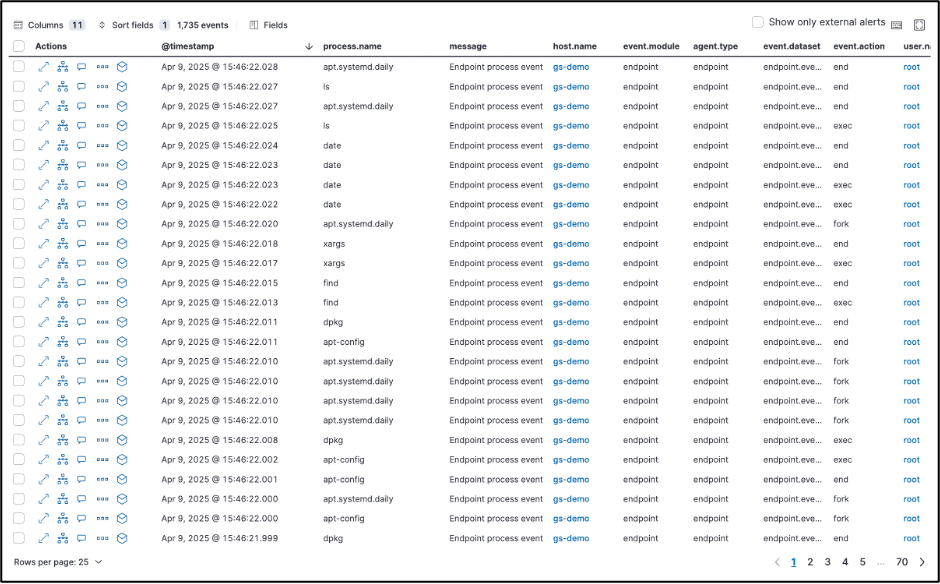

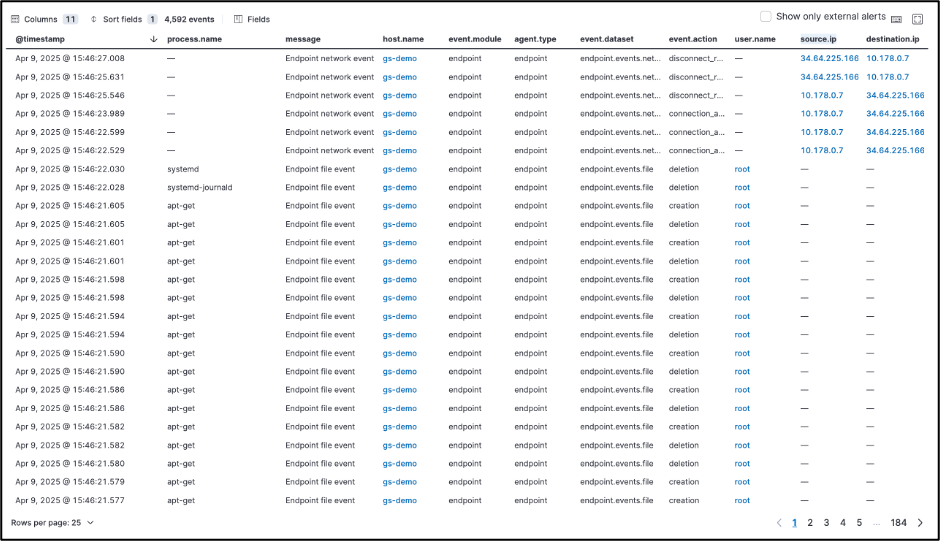

머신 러닝을 이용해 희귀(Rare) 조건의 데이터를 학습하고 자동으로 새로운 위험을 구분 합니다. Elastic Security로 수집된 인덱스에서 목적에 맞는 데이터를 추출하여 별도의 데이터셋을 생성한 후 ML학습을 수행할 수 있으며 운영자는 학습 결과를 스코어링(또는 그래프)와 같이 직관적으로 확인할 수 있도록 기능을 제공하고 있습니다. (※ ML Job 생성 및 확인). 아래는 실제 보안솔루션(IPS / 웹방화벽 / DDoS 대응 솔루션)에서 탐지된 이벤트를 추출하여 Rare 함수 기반 ML학습을 수행한 결과 일부입니다.

Elastic Security는 생성된 ML Job 의 스코어링 값(1~ 99)을 기준으로 ML 룰을 작성할 수 있습니다. 아래는 작성된 ML룰에 의해 탐지된 Alerts입니다. 보안 장비(DDoS/WAF/IPS) 이벤트(알람)를 기준으로 최근 한달 동안 탐지되지 않던 이벤트(알람)이 발생하면 머신 러닝 학습을 통해 경보를 발생 합니다.

5. 머신 러닝 유즈케이스: 네트워크 이상 트래픽 모니터

비정상적으로 크게 급증하는 패턴을 탐지하는 것은 서비스 가용성을 확보하는데 가장 중요한 방법 중 하나입니다. 일반적인 비즈니스 흐름이나 네트워크 운영에서 전혀 예상되지 않는 트래픽이 발생할 때 더욱 의심스러운 징후가 됩니다. 이는 내부 시스템에서 외부의 악의적인 대상으로 대량의 데이터가 전송될 수 있으며, 외부에서 내부로 비정상적인 네트워크 연결 증가나 실패는 서비스 제공에 심각한 문제가 발생한 징후일 수 있습니다.

이러한 유즈케이스를 탐지하기 위해 우리는 Elastic ML의 비지도 학습 기능을 사용하여 네트워크 데이터의 정상적인 패턴을 학습하고 이 패턴에서 벗어나는 행위를 자동으로 찾아냅니다. 사용되는 ML Job high_count와 같은 형태로 정의될 수 있는데, 이는 네트워크 활동의 정상 범위를 모델링하고 이 범위를 벗어나는 활동을 이상 징후로 탐지합니다.

실제 국내 운영 사례로 다음과 같이 프토토콜에 따른 트래픽을 학습하고 이상 징후를 선제적으로 대응에 활용되는 사례를 설명 합니다.

유즈케이스: TCP/UDP/ICMP/TLS 기반 High Count 머신 러닝 룰

| Job/Rule 명 | 분석 목적 | 필드 데이터 |

| protocol_pps_rcvd | PPS/수신 바이트 급증 | pps.packets_pps : 수집 트래픽 내 유입량 정보(패킷 수 기반) |

| protocol_udp_bytes | UDP 트래픽 급증 | 수집 트래픽 내 유입량 정보(Inbound 기반) |

| protocol_tcp_bytes | TCP 트래픽 급증 | procotol.*.bytes : 수집 트래픽 내 각 프로토콜 별 유입량 정보 |

| http_bytes | 웹 트래픽(HTTP) 급증 | procotol.*.bytes : 수집 트래픽 내 각 프로토콜 별 유입량 정보 |

| anomaly_outbound | 아웃바운드 의심 트래픽 | tx_rx.sent_bytes : 수집 트래픽 내 유입량 정보(Outbound 기반) |

유즈케이스: TCP/UDP/ICMP/TLS 기반 High Count 머신 러닝 운영 팁

- Bucket Span 조정 목표: 단발성 트래픽 스파이크로 인한 오탐(False Positive)을 줄이고, 이상 트래픽이 지속되는 패턴을 더 명확하게 식별하여 탐지 명확도를 높이는 데 중점을 두었으며, 이를 통해 최적화 튜닝을 진행했습니다.

- 룰의 민감도 및 정확도 개선을 위해 주요 ML 룰의 Bucket Span 설정을 기존 1분에서 10분 단위로 조정하여 탐지 성능 개선

- 기존 1분 단위로 판단을 진행하고 있으며, 이로 인해 단기간에 1회성으로 발생한 통신에 대해서도 높은 점수로 평가되는 경향을 보여 5~10분 단위로 분석 주기를 늘려 탐지 프로필의 정교함을 증가 시킵니다.

- 트래픽 유입량(bps) 및 패킷 건수(pps)를 기반으로 분석을 수행해 데이터 값이 평시대비 커지긴 하였으나, 절대적인 수치는 낮은 경우(몇 백 kbits)가 높은 점수로 평가되는 경향을 보여 다수의 탐지 사례가 발생하기 때문에 출발지 IP의 Unique Count를 분석 데이터에 포함하여, 출발지 IP가 함께 상승하는 경우를 탐지(DDoS의 특징을 고려)

유즈케이스 탐지 예제: 머신 러닝을 통해서 아웃바운드 통신 급증 경보 발생

- @timestamp: Aug 27, 2024 @ 14:53:06.221

- 출발지 IP: 192.168.221.128

- 도착지 IP: 185.125.190.36 / Country GB, Continent EU, Network 185.125.190.0/24

- kibana.alert.rule.type: machine_learning

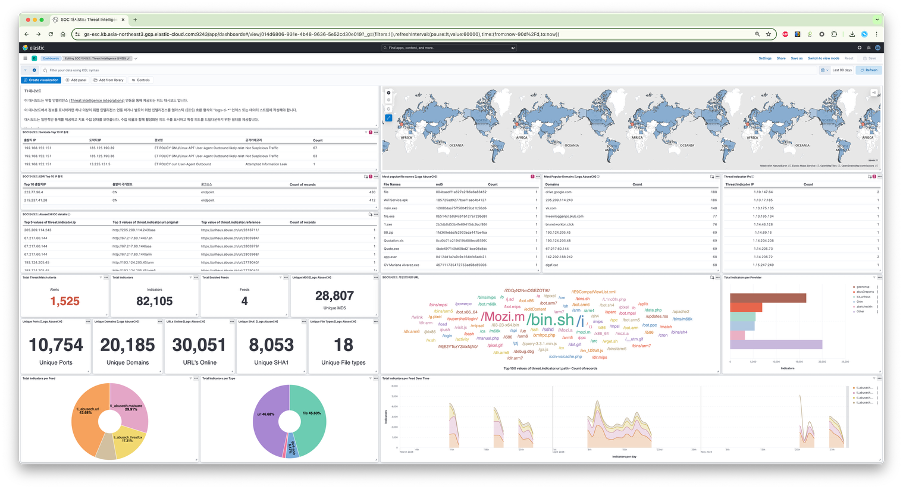

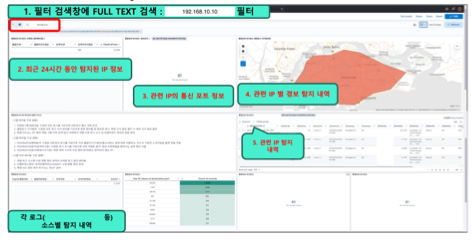

탐지된 정보를 활용해 대시보드를 구성할 수 있습니다. 보안 유즈케이스와 인프라 모니터 유즈케이스 모두 해당 합니다. 다음은 샘플 화면 사례 입니다.

탐지된 정보를 기반으로 의심 국가나 지리정보를 기반으로 심층 분석 진행으로 이어 집니다.

6. 머신 러닝 유즈케이스: 개인업무 고객정보조회 모니터

개인정보 유출 사고가 발생하면 기업 입장에서 중요한 비지니스 영향을 받습니다. 사고 조사 과정에서 개인정보 유출 시점에 일반적인 업무 절차와 다른 다양한 이상 징후가 확인 됩니다. 대표적인 개인정보 유출 사례를 다음과 같습니다.

- 권한 오남용: 고객 정보에 접근 권한을 가진 내부자가 권한을 악용하여 비정상적으로 다량의 정보를 조회(예: 비정상적인 조회 패턴)하는 행위를 식별합니다.

- 보안 사고: 개인정보 유출 사고 발생 시 대량의 정보 유출로 인한 이상 트래픽 발생이나 의심스러운 네트워크 통신을 통해 정보 유출 행위를 식별 합니다.

Elastic 머신 러닝을 활용해 정보 유출 의심 사례를 탐지한 사례를 살펴 보겠습니다. Elastic 머신 러닝은 다양한 조건을 이용해 정보 유출 행위를 탐지 합니다. 평소 정상 활동에 대한 패턴 학습을 통해 비정상적인 활동에 대한 임계치를 자동으로 생성 하고 임계치를 초과할 경우 경보를 통해 자동으로 알람을 발생 시킵니다.

| 머신러닝(ML) 학습유형 | 설명 | ML 설정 요소 |

| 단일 메트릭 이상 탐지 (Single Metric Anomaly Detection) | 평소 조회 건수의 시간별/일별 패턴을 학습하여, 갑작스러운 조회 건수의 급증을 탐지합니다. | Detector: high_count (조회 건수) |

| 다중 메트릭 이상 탐지 (Multi-Metric Anomaly Detection) | 전체 조직의 조회 건수 패턴을 학습하는 동시에, 각 사용자(user.id) 별로 메트릭을 분리(Split by)하여 개별 사용자의 비정상적인 행동을 정교하게 탐지합니다. | Detector: high_count (조회 건수) Split by: user.id (직원 계정) |

| 모집단 이상 탐지 (Population) | 조직 내 다수의 직원이 특정 시점에 공통적으로 비정상적인 시간대에 조회하는 경우(예: 주말 새벽) 또는 평소 사용하지 않던 **희귀한 애플리케이션(application.name)**을 통해 조회하는 행위를 탐지합니다. | Detector: high_non_zero_count Influencer Field: user.id, application.name |

개인업무 고객정보조회 건수 모니터 사례

- 직원정보, 고객 정보 조회 대응

영업점에서 근무하는 직원들의 고객정보화면 조회 건수를 학습하여, 타 직원에 비하여 많은 고객정보조회를 하는 직원 식별 목적의 머신 러닝 적용 사례를 소개 합니다.

그림. 임직원 고객 정보 조회 건수 머신 러닝 분석 결과

권한 없는 사용자가 특정 날짜에 고객정보 조회를 과도하게 조회할 경우 다음과 같이 기존 학습한 개인 정보 조회 건수를 기반으로 이상 행위를 탐지 합니다. 급격히 개인정보 조회건수가 증가하여 개인정보 유출 징후를 식별 할 수 있습니다.

실제 정보 유출에 연관되지 않았지만 가맹점에서 마케팅 목적으로 회원 정보에 대한 조회가 평소 대비 급증하였고, 개인 정보 유출 상황에 대해 적극적으로 탐지/대응이 가능 합니다.

퇴직자 또는 퇴직 예정자의 업무 시스템별 이상 행위 모니터

- 퇴직자 또는 퇴직 예정자의 업무시스템별 사용량 패턴 및 이상행위를 탐지

퇴직자 또는 퇴직 예정자의 평소 업무 시스템별 사용량을 기반으로 퇴직 전후의 이상 사용량 패턴을 분석 합니다.

| 징후 유형 | 상세 설명 | 머신 러닝 (ML) 학습 방식 |

| 비업무 시간 접근 | 직원의 일반적인 근무 시간이 아닌 새벽, 주말, 공휴일에 고객 정보를 조회하는 행위. | Time Series Anomaly Detection, time_of_day 함수 |

| 특정 기간 급증 | 단기간(예: 1시간, 1일) 동안 조회량이 이전 30일 평균 대비 임계치를 초과하여 폭발적으로 증가하는 경우. | high_count Detector, Influencer로 time 필드 사용 |

| 희귀한 대상 접근 | 해당 직원이 평소 업무와 무관한 특정 고객군(예: VIP 고객 명단, 파산 고객 명단)의 정보를 조회한 경우. | rare Detector, Partition Field로 customer.type 사용 |

다양한 개인정보 또는 정보보호 솔루션을 이용해 평소 학습량을 분석 합니다. 아래는 샘플로 복합기/정보보호 프라이버시 솔루션/자료반출승인 관련 시스템의 로그 정보를 학습해 평소 대비 이상 징후와 연관된 사용자를 식별할 수 있습니다.

7. 머신 러닝 유즈케이스: 이상거래탐지

금융 거래 중 보이스 피싱 또는 최근 보이스피싱과 피싱 사기는 갈수록 지능화되고 있으며, 범죄 수익금을 은닉하고 세탁하기 위해 대포통장 활용이 급증하고 있습니다. 금융기관의 기존 FDS(Fraud Detection System)는 주로 단순 임계값이나 미리 정의된 규칙(Rule-based)에 의존하기 때문에, 범죄자들이 이 규칙을 우회하는 새롭고 미묘한 이상 패턴을 실시간으로 포착하는 데 한계가 있습니다.

사기거래 탐지 유즈케이스 한계

- 정적 규칙 의존: 규칙 기반 시스템은 알려진 공격 패턴에만 효과적이며, 신종 수법이나 변형된 패턴에 취약합니다.

- 오탐(False Positive) 증가: 민감도를 높이기 위해 규칙을 강화할 경우 정상 거래까지 이상 거래로 분류하여 사용자 불편과 분석가의 피로도를 증가시킵니다.

- 탐지 지연: 사기 행위가 완료된 후, 데이터를 사후 분석(Post-process)하는 경우가 많아 실시간 대응이 어렵고 피해 확산을 막기 어렵습니다.

Elastic 머신러닝(ML) FDS의 역할

Elastic Machine Learning 기반 FDS는 거래 데이터의 정상적인 행동 패턴을 스스로 학습하고, 정상 범위를 벗어나는 모든 비정상적인 행위(이상 징후, Anomaly)를 실시간으로 식별하여 이러한 한계를 극복합니다. 이는 대포통장을 통한 자금 이동의 특이성과 연속적인 행위를 포착하는 데 필수적입니다.

대포통장이 보이스피싱에 연루될 경우, 범죄자들은 피해금을 신속하게 분산시키거나 인출하기 위해 일련의 비정상적인 거래 시퀀스를 발생시킵니다. Elastic 머신러닝(ML)은 이러한 점검/테스트 행위와 “대량 인출 행위”의 연관성을 탐지하는 데 집중합니다.

사례 1: 미사용 계좌의 갑작스러운 고액 거래 및 시간대 이탈

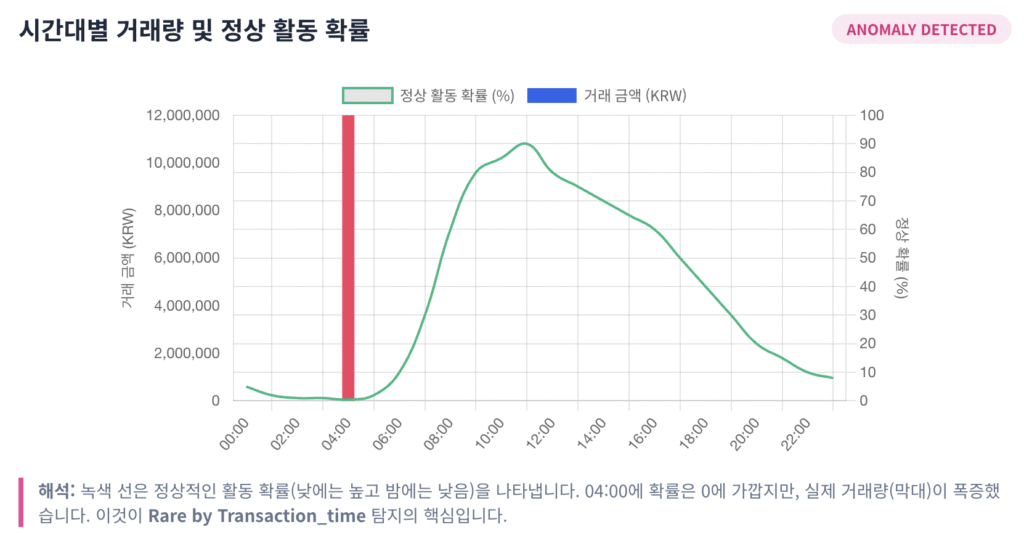

시나리오: 오랫동안 사용되지 않던 계좌(대포통장)가 평소 거래가 전혀 없던 시간대에 활성화되어 소액(1,000원)을 입금한 후, 30분 뒤 고액(1,200만 원)을 인출하는 행위.

이상 징후:

- 범인이 4시에 A 통장의 거래 가능 상태 여부를 확인하기 위해 1천원을 입금했다.

- 30분 뒤 범인 E가 A 통장에서 1,200만원을 인출했다.

이상 행위 발생 순서

- 범인이 4시에 A 통장의 거래 가능 상태 여부를 확인하기 위해 1천원을 입금했다.

- 한번도 거래 한적이 없던 계좌를 통해 거래 확인

- 시간대 이탈: 계좌 주인(혹은 피해자)의 평소 입출금 활동 시간대가 아닌 희귀한 시간대에 거래 발생.

- 범인이 30분 뒤A 통장에서 1,200만원을 인출했다.

- 최초 거래 주체: 거래 내역이 없던 **새로운 계좌(범인 계좌)**를 통해 거래 확인

- 한번도 거래 한적이 없던 계좌를 통해, 평소 입출금이 발생하는 시간이 아닌 시간에 처음 거래 발생

Elastic Machine Learning 적용 방안

대포통장 연관 이상 행위 탐지를 위해 Elastic Stack은 비지도 학습(Unsupervised ML) 기반의 이상 징후 탐지를 사용합니다.

- 비지도 학습: 희귀 패턴 탐지 (Rare Function): 대포통장 활성화는 전체 거래 모집단에서 매우 드문 이벤트이므로, Rare 함수를 활용하여 새로운 조합의 행위를 탐지합니다.

- ML Job 유형: Anomaly Detection – Rare (희귀 함수)

- 탐지 필드: Transaction_time (거래 시간)과 Withdrawal_Account (출금 계좌) 조합.

작동 원리: 평소 특정 시간대에 특정 계좌를 통해 거래가 이루어질 확률을 모델링하고, 새로운 계좌가 비정상적인 시간대에 거래하는 행위를 높은 이상 징후 점수로 식별합니다.

- 이상 징후 시간: 2023년 3월 26일 04:00 (Severity: Warning)

- 탐지 이유: rare by Transaction_time (거래 시간 기준 희귀 이벤트)

- 영향 요인 (Influencers):

- Transaction_time: 04:00 (접속한 적 없는 비정상적인 시간대)

- Withdrawal_Account: 5161-3185-197 (한 번도 거래한 적 없던 계좌)

Elastic 머신러닝(ML) 기반 FDS는 실시간으로 진화하는 보이스피싱 및 대포통장 사기 수법에 효과적으로 대응할 수 있는 필수적인 기술입니다. 단순 규칙 기반 탐지에서 벗어나 데이터의 본질적인 특이성과 복합적인 거래 시퀀스를 학습하고 분석함으로써, 금융기관은 사기 피해를 최소화하고 고객의 자산을 보호할 수 있습니다.

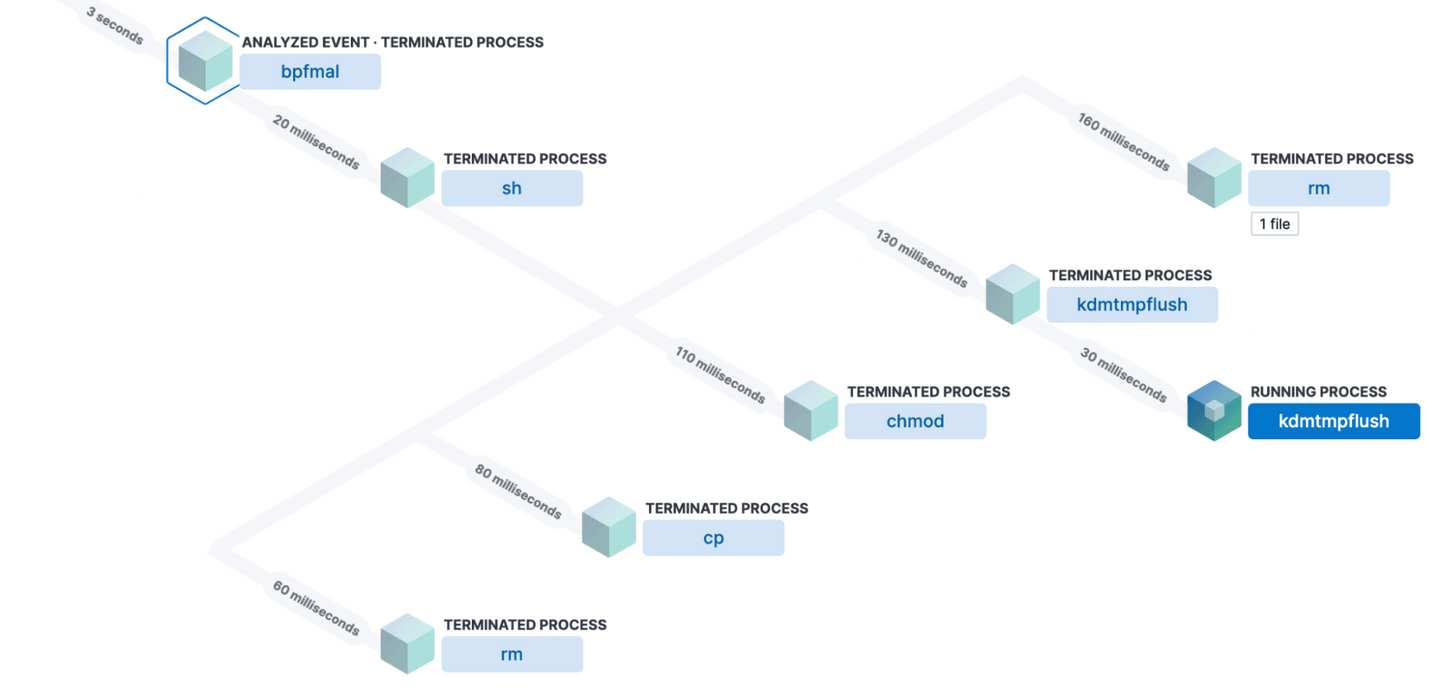

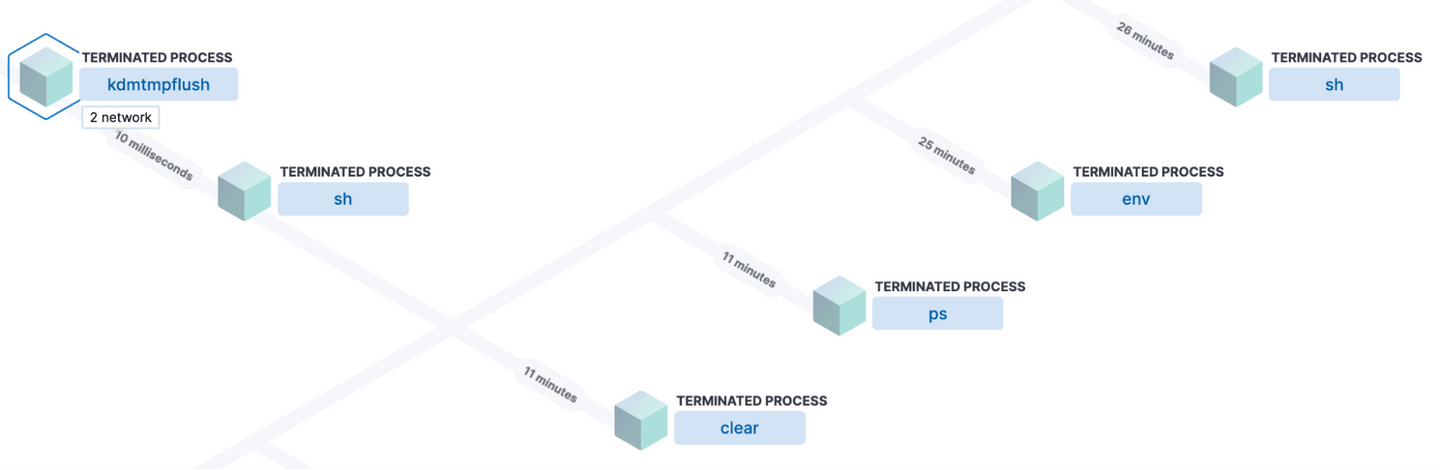

8. 머신 러닝 유즈케이스: 악성코드 배포 탐지

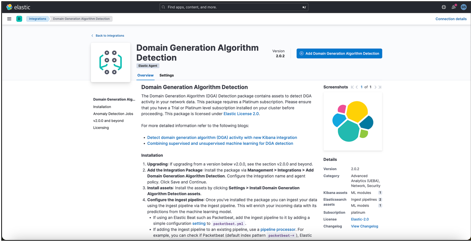

도메인 생성 알고리즘(Domain Generation Algorithm, DGA)은 악성코드 제작자가 감염된 클라이언트 컴퓨터와 명령 및 제어(C2) 서버 간의 통신을 숨기기 위해 사용하는 기술입니다.

- Domain Generation Algorithm: https://www.elastic.co/security-labs/detect-domain-generation-algorithm-activity-with-new-kibana-integration

DGA는 수백 또는 수천 개의 무작위로 생성된 도메인 이름을 동적으로 생성하며, 이 중 하나만이 C2 서버의 IP 주소로 확인됩니다. 이는 방어 시스템이 단순한 도메인 차단 목록(Blocklist)으로 악성 도메인을 차단하는 것을 불가능하게 만들어, 멀웨어의 지속성을 높이는 핵심 요소입니다.

DGA 탐지 패키지는 다음 핵심 요소를 포함합니다.

- 지도 머신러닝 모델 (Trained Model): DGA 패턴을 학습한 분류 모델로, DNS 쿼리 데이터가 악성(DGA)일 확률을 예측합니다.

- 수집 파이프라인 구성 (Ingest Pipeline): 수집 시점(Ingest Time)에 모델을 적용하여 들어오는 DNS 로그를 즉시 보강하는 프로세스를 정의합니다.

- 추론 프로세서 (Inference Processor): 수집 파이프라인 내에서 지도 학습 모델(ml_dga_inference_pipeline)을 호출하여 DNS 쿼리 필드에 대해 DGA 확률 점수를 부여합니다.

- 이상 징후 탐색 Job (Anomaly Detection Jobs): ML 모델의 예측 결과(확률 점수)를 기반으로 비지도 학습을 수행하여 이상 징후를 탐지합니다.

- 탐지 규칙 (Detection Rules): Kibana의 규칙 엔진에서 이상 징후 Job의 결과를 참조하여 최종 경보를 발생시킵니다.

Elastic Security의 DGA 탐지 통합 패키지는 지도 학습 모델을 Kibana 내에 통합하여, 방어 시스템이 피하기 어려웠던 DGA 기반 C2 통신을 효율적으로 식별할 수 있는 강력한 방어 메커니즘을 제공합니다. 이는 수집 시점의 데이터 보강과 ML 기반의 행동 분석을 결합함으로써, 최신 멀웨어 위협에 대한 선제적 보안 대응 능력을 대폭 강화합니다.

9. Elastic 머신 러닝 기술 자료

- Elastic 머신 러닝: https://www.elastic.co/guide/en/machine-learning/current/machine-learning-intro.html

- 머신 러닝 Job types: https://www.elastic.co/guide/en/machine-learning/current/ml-anomaly-detection-job-types.html

- Security anomaly detection configurations: https://www.elastic.co/docs/reference/data-analysis/machine-learning/ootb-ml-jobs-siem

- Machine learning analysis function reference: https://www.elastic.co/guide/en/machine-learning/current/ml-functions.html

- 머신 러닝 학습 설정 가이드: https://www.elastic.co/docs/explore-analyze/machine-learning/anomaly-detection/ml-ad-run-jobs#ml-ad-cardinality

- 머신 러닝 알고리즘: https://www.elastic.co/kr/blog/popular-ml-algorithms